هل أفرطنا في الثقة بالتكنولوجيا وهل نستطيع التراجع؟

يبدو الجدل الواسع بشأن مدى الثقة التي يمكن أن نمنحها للتكنولوجيا، يائسا وعقيما، في ظل اقترابنا المتسارع من نقطة اللاعودة، حين تهيمن التكنولوجيا على حياتنا ولا نستطيع الفكاك من قبضتها وإعادة عقارب الساعة إلى الوراء، رغم أن الخبراء يقولون إن إفراط البشر في الثقة في التكنولوجيا يناسب عكسيا مع تراجع ثقتهم بأنفسهم.

يشير التاريخ القصير لتسليم القرارات للقيادة الآلية والتكنولوجيا الخارجة عن سيطرة البشر، إلى سلسلة طويلة من الأخطاء المأساوية، بسبب فشل البرمجيات في الاستجابة خارج المنطق الرقمي المغلق.

قد يذهب بعضهم إلى الأخطاء الكبرى، التي تحتل عناوين الأخبار فقط، مثل سقوط طائرتي ركاب من طراز بوينغ 737 ماكس الأولى في أكتوبر 2018 ومارس 2019 ومقتل 346 شخصا بسبب خلل في البرمجيات.

لكن البيانات تظهر أن الاعتماد على أنظمة اتخاذ القرار الآلية تسبب مرارا وتكرارا في وقوع الملايين من جميع أنواع الأخطاء، التي تمتد من ضياع الاستثمارات إلى تشخيصات طبية قاتلة وصولا إلى اعتقال كثيرين دون ذنب، عدا عما لا ينبه البشر إلى مسؤولية الآلة عن وقوعه.

ومع كل ذلك لا تزال القناعة الشائعة بأن “الكمبيوتر لا يمكن أن يكون خطأ” صامدة في الكثير من الأوساط والمجتمعات.

وتزداد خطورة ذلك مع انفجار مستويات الاعتماد على التكنولوجيا في اتخاذ القرارات الأكثر تعقيدا دون أن يتمكن أحد من الوقوف بوجه هذا الزخم المتسارع، الذي يكاد يكون قد خرج بالفعل عن نطاق السيطرة.

على سبيل المثال، لم تعد المصارف وصناديق الاستثمار العالمية قادرة على وقف استخدام الذكاء الاصطناعي في اتخاذ قرارات إدارة الاستثمار، في ظل سباقها لخفض تكاليف التشغيل وعدم قدرة البشر على أخذ كميات هائلة من البيانات في الحسبان عند تحويل الرهان من أداة مالية إلى أخرى.

ويثير ذلك جدلا مكتوما حول مسؤولية ضياع أموال المستثمرين حين لا يكون هناك شخص يمكن إلقاء اللوم عليه في ذلك، وهو جدل قانوني يتسع يوما بعد يوم.

نقطة اللاعودة

قد يبدو للبعض أن اعتمادنا على التكنولوجيا لا يزال في بداياته وأننا لا نزال نملك مفاتيح القرار، حيث لا توجد حتى الآن سيارات ذاتية القيادة خارج تجارب أولية محدودة، أو طائرات تستغني تماما عن الطيارين.

لكن وظيفة السائق في أحدث طرازات السيارات ونماذجها المستقبلية بدأت تقتطع بالفعل حصة كبيرة من دوره ولن يمر وقت طويل قبل أن تنتفي الحاجة إلى تدخله وتصبح السيارات ذاتية القيادة بالكامل.

أما الطائرات الحديثة فإن دور الطيار أصبح محدودا حيث تقوم أنظمة الملاحة بمعظم الوظائف. لا يزال الطيار يحتفظ بتوجيه الطائرة في اللحظات الحاسمة، لكن دوره يتضاءل وقد تنتفي الحاجة إليه في المستقبل، إلا أن دور البرامج الآلية هو الذي أسقط طائرتي بوينغ 737 ماكس.

وتظهر النظرة المتفحصة أن التكنولوجيا تسللت بالفعل أبعد من ذلك بكثير وتوغلت في القواعد العميقة، دون أن تظهر مخالبها في العناوين الكبرى.

لا يمكن الإحاطة بجميع أعماق اعتمادنا المفرط على الهواتف الذكية، فهي ليست مجرد تطبيقات واتصالات وألعاب بل هي مكتبة بياناتنا وذاكرتنا، وما ينطوي عليه ذلك من ثغرات يمكن التسلل من خلالها والتحكم بحياتنا أو حتى تدميرها بالكامل.

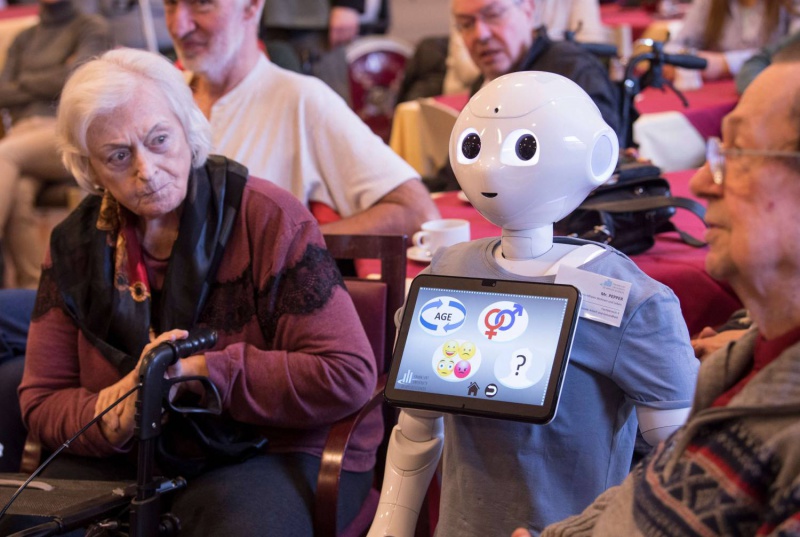

هل نستطيع اليوم العودة إلى الوراء وتقليص اعتمادنا على الهواتف الذكية التي أصبحت داعما أساسيا لمعظم نشاطات حياتنا؟ إذا كان ذلك ممكنا بالنسبة للأجيال الأكبر سنا، التي عاشت معظم حياتها دونها، فإن الأمر يختلف مع الأجيال التي ولدت وفي يدها هواتف ذكية!

دور تلك الأجهزة يتسع يوما بعد يوم مع انتشار المساعدات الصوتية مثل أليكسا وسيري، التي أخذت تؤثث مساحات أكبر من تفاصيل حياتنا مع تزايد ذكائها الاصطناعي.

يبدو في القمة الطافية من جبل الجليد، أننا لا نزال نملك جميع القرارات، لكن الجزء الغاطس الهائل الحجم أصبح خارج سيطرتنا وقد لا نستطيع استعادة السيطرة عليه، في وقت نقترب فيه بشكل متسارع من فقدان السيطرة على القمة الطافية أيضا.

وهنا تدور المعارك الكبرى حول وضع مبادئ “أخلاقية” تحكم سلوك التكنولوجيا وحول مدى الثقة التي نضعها فيها. وما هي الأخطاء التي يمكن أن ترتكبها ومن الذي سيتحمل مسؤولية ذلك؟

هل سنتمكن من استعادة زمام الأمور حين تكثر أخطاء الأنظمة الآلية وتتحول إلى سياق يكتسب زخمه من ذكائها، الذي يقترب من التفوق على ذكاء البشر؟

قبل عامين حين ارتكبت القيادة الذاتية في تجارب سيارة تسلا، خطأ فادحا أدى إلى مقتل شخص، أظهرت نتائج تقرير المجلس القومي الأميركي لسلامة النقل أن السيارة فشلت في قراءة أحوال الطريق بشكل صحيح وتسارعت بدل كبح الفرامل، فيما كان السائق مشغولا باستخدام هاتفه.

وقال رئيس المجلس روبرت سوموالت إن الحادث لم يكن فقط بسبب العيوب في القيادة الذاتية بل في اعتمادنا المفرط عليها وعدم وضع قواعد لاستخدام التكنولوجيا الجديدة.

اتساع الجدل والمخاوف

يرى جون ثورنهيل في مقال في صحيفة فايننشال تايمز أن تحذيرات علماء الكمبيوتر بدأت تتصاعد من المخاطرة بالاعتماد على أنظمة الذكاء الاصطناعي في اتخاذ القرارات السريعة والحساسة، لتفادي اعتراف المسؤولين بعدم اليقين وقبول إمكانية تناقض القرارات والنتائج.

ويعبر نيل لورنس أستاذ التعلم الآلي في جامعة كامبريدج، عن قلقه المتزايد من الوعود غير الواقعية التي يقطعها منتجو برامج الذكاء الاصطناعي عن قدرتهم على إدخال الحس السليم في أنظمة الكمبيوتر.

ويضيف أن المشكلة تكمن في أن قرارات الإنسان غالبا ما تكون غير منسجمة أو غير كاملة أو مخطئة، لأن عدم اليقين سمة مرتبطة بحياة الإنسان ولأن الواقع الحقيقي يفاجئنا باستمرار ويفعل أشياء غريبة.

ويستدرك قائلا إن ذلك لا يعني إنكار أن نماذج الكمبيوتر يمكن أن تكون مفيدة بشكل لا يصدق، حتى في ظروف عدم اليقين، لكن يجب أن تبقى هناك قيود على استخدامها باستمرار.

ويشير لورنس في دراسة بعنوان “صنع القرار والتنوع” إلى مقولة للخبير الإحصائي جورج بوكس، الذي يرى أنه “بما أن جميع النماذج خاطئة، يجب على العالم أن يكون متيقظا لما هو مهم. إذ من غير المناسب أن نشعر بالقلق لوجود فئران عندما تكون هناك نمور حولنا”.

ويؤكد في كتابه “من يقود الابتكار؟” على أن التعلم من عيوب الآلات قد يكون بنفس أهمية فهم إخفاقات البشر. ويجادل جاك ستيلغو أستاذ العلوم الاجتماعية في يونيفرستي كوليدج في لندن، بأن التقدم في التعلم الآلي يجب أن يكون مصحوبا بالتعلم الاجتماعي.

البحث عن حلول

يقول ثورنهيل إن هناك نموذجين تنظيميين عامين، الأول هو “الحكم الاستباقي” الذي تمارسه إدارة الغذاء والدواء الأميركية، حيث تخضع جميع الأدوية لتجارب سريرية واسعة ومراجعة تنظيمية قبل السماح لاستخدامها من قبل الجمهور.

أما النموذج الثاني فهو الحوكمة بعد وقوع الأخطاء، على النحو الذي يطبقه المجلس الأميركي لسلامة النقل، والذي يبدو مثيرا للقلق لكنها أثبتت فعاليته في تحسين سلامة شركات الطيران، بعد وقوع أخطاء كارثية. ويضيف أنه ربما هناك حاجة لابتكار المزيد من النماذج التنظيمية.

ويرى ستيلغو أن البشر أمام خيارين؛ إما توفير الحماية قبل المضي قدما أو المضي قدما وانتظار النتائج. لكنه يقترح أن يكون الأمر الأساسي هو “خلق قدرة مجتمعية على فهم التقنيات الناشئة واتخاذ قرار بشأن الإطار التنظيمي المناسب. لا يمكننا ترك كل هذا للشركات الخاصة القوية”.

ويبدو حتميا أن يكون على الشركات واجب الامتناع عن إطلاق منتجات غير مجربة في السوق. لكن ينبغي أيضا على كل مستخدم أن يتحمل مسؤولية توخي الحذر اللازم.

ويشير ثورنهيل على سبيل المثال إلى أن إدارة المحميات الطبيعية الأميركية الواسعة تحث جميع زوار “وادي الموت” على حمل خرائط محدثة وممارسة الفطرة السليمة بسبب ضعف الاتصالات في المنطقة وتحذر من الاعتماد فقط على أنظمة تحديد المواقع “جي.بي.أس”.

ويقول إن ذلك يبدو تحذيرا عاما، ينبغي أن ننتبه إليه جميعا عند استخدام التكنولوجيا الآلية.

أما الآفاق المستقبلية لاتساع استخدام الذكاء الاصطناعي في كل شيء فتنذر بمخاطر أكبر خارج سيطرة البشر. ولذلك اتسع الجدل بشأن وضع قواعد لاستخدام تلك التقنيات.

أخلاق للتكنولوجيا

في يناير الماضي اقترحت الإدارة الأميركية 10 مبادئ لأخذها في الاعتبار عند وضع القوانين والقواعد اللازمة لاستخدام الذكاء الاصطناعي في القطاع الخاص.

ويتزامن ذلك مع سباق هيئات دولية كبرى مثل منظمة التعاون الاقتصادي والتنمية ومجموعة الدول الصناعية السبع الكبرى والاتحاد الأوروبي لتنظيم استخدام الذكاء الاصطناعي.

وفي مارس 2019 اتفقت أكثر من 50 شركة ألمانية على قيم أخلاقية تلتزم بها في مجال الذكاء الاصطناعي وقامت بصياغة تلك القيم في شكل شعار جودة سوف يتم تحويله لاحقا إلى علامة تجارية. وأعلنت الرابطة الألمانية للذكاء الاصطناعي أن شعار الجودة يركز على الحفاظ على القيم الأساسية الأخلاقية والتعامل الآمن والمتوافق مع حماية البيانات المستخدمة.

وذكرت الرابطة أن قائمة القيم الأساسية تتضمن تعهد جميع الشركات بضمان عدم التحيز في قاعدة البيانات المستخدمة والأسلوب الشفاف في تطوير تقنيات الذكاء الاصطناعي دون إخفاء أي سياسات يمكن أن تؤثر على المستهلكين.

وألزمت الشركات نفسها بالتركيز على مصالح الناس أثناء تطوير وتطبيق الذكاء الاصطناعي كما تلتزم أيضا “بالقيم الأساسية الأوروبية وهي الكرامة الإنسانية والحرية والديمقراطية والمساواة وسيادة القانون”.

وتحاول جميع تلك الجهود الإجابة على سؤال حول إمكانية أن تحافظ الأنظمة الآلية على القيم الأساسية الأخلاقية، في ظل مخاوف شائعة من أن الذكاء الاصطناعي يمكن أن ينقلب على مصالح البشر.

ويقول رئيس الرابطة يورغ بينرت إن خبراء الذكاء الاصطناعي في الشركات الألمانية وضعوا مبادئ لقضايا أخلاقيات حماية البيانات وقيم التعددية وعدم التمييز والتسامح والعدالة والتضامن والمساواة بين الجنسين.