قانون أوروبي للذكاء الاصطناعي.. كلما زادت المخاطر زادت القواعد

يسارع الاتحاد الأوروبي الخطى نحو وضع قواعد للذكاء الاصطناعي فيما يتفاوض على قانون يحذر المستخدمين من المحتوى الذي يولّده الذكاء الاصطناعي الذي يمكن أن يؤدي إلى معلومات مضللة، والسؤال الذي يفرض نفسه في هذا السياق هو: هل تذعن الشركات لذلك؟

ستراسبورغ (فرنسا) - يعتزم البرلمان الأوروبي تنظيم استخدام الذكاء الاصطناعي، ويقول إنه سيخضع لقواعد أشد صرامة.

وكشف أعضاء البرلمان الأوروبي عن مواقفهم خلال اجتماع الأربعاء في مدينة ستراسبورغ، قبل طرح مسودة القانون للتفاوض مع دول الاتحاد الأوروبي من أجل الوصول إلى اتفاق على الصيغة النهائية لقانون الذكاء الاصطناعي.

وقال البرلمان الأوروبي إن قانون الذكاء الاصطناعي سيكون أول قانون شامل على مستوى العالم ينظم التعامل مع هذه التكنولوجيا الجديدة.

وبحسب إطار العمل القانوني، سيتم تقسيم أنظمة الذكاء الاصطناعي إلى مجموعات مخاطر مختلفة، وكلما زادت المخاطر التي يمثلها أي تطبيق زادت صرامة القواعد المنظمة له.

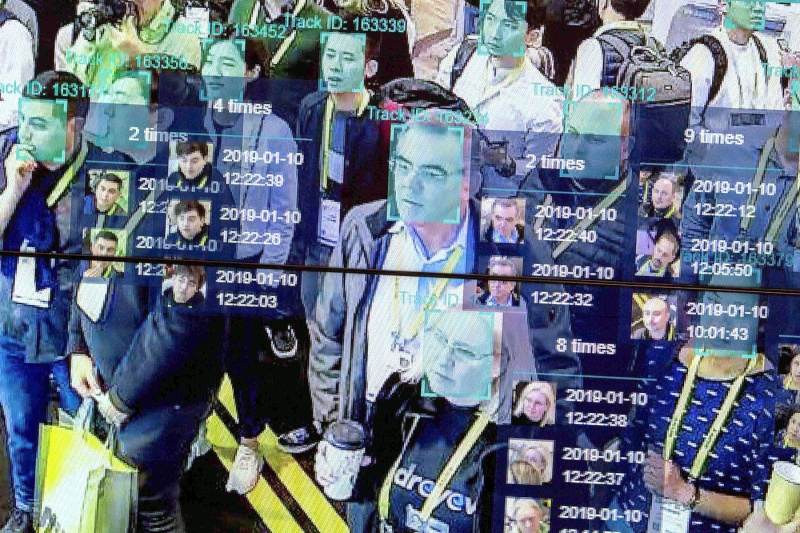

كما سيدرس البرلمان إمكانية فرض حظر كامل على خصائص مثل التعرف الفوري على الهوية باستخدام ملامح الوجه في الأماكن العامة. وسيتم حظر أي تطبيقات تصنف الأشخاص على أساس سلوكهم الاجتماعي أو سماتهم العرقية.

ويريد الاتحاد الأوروبي من شركات التكنولوجيا أن تحذر المستخدمين من المحتوى الذي يولده الذكاء الاصطناعي الذي يمكن أن يؤدي إلى معلومات مضللة، في إطار قانون طوعي.

وقالت فيرا جوروفا، وهي نائبة لرئيس المفوضية الأوروبية، لئن كان “بإمكان تكنولوجيا الذكاء الاصطناعي أن تكون قوة من أجل الخير” فإن هناك “جوانب مظلمة” ذات “مخاطر جديدة ومن المحتمل أن تخلّف عواقب سلبية على المجتمع”.

وتابعت “تثير التكنولوجيات الجديدة تحديات جديدة في الحرب ضد المعلومات المضللة”.

وأضافت جوروفا أنه يجب على الشركات التي وقعت على القانون الطوعي لمكافحة المعلومات المضللة، التابع للاتحاد الأوروبي، أن تؤشّر بشكل واضح على أي خدمة من المحتمل أن تسهم في نشر معلومات مضللة يولدها الذكاء الاصطناعي.

ومن بين الشركات الموقعة على القانون تيك توك ومايكروسوفت وميتا بلاتفورمس.

وكان سام ألتمان، مدير شركة أوبن إيه آي التي طورت برنامج المحادثة “تشات جي بي تي”، قد حذر من المبالغة في التنظيم، لكنه تراجع عن تهديده السابق بعدم توفير خدمات “تشات جي بي تي” في أوروبا. وأشار إلى أن وضع قواعد للذكاء الاصطناعي أمر جيد من حيث المبدأ، لكن “نحتاج إلى الوضوح”.

حتى مطورو النظام وكبار مدراء مايكروسوفت وغوغل يعترفون بأنهم لم يعودوا يعرفون بالضبط كيف تعمل تطبيقات الذكاء الاصطناعي.

وهو ما دفع بأحد آباء الذكاء الاصطناعي، الموظف السابق لدى غوغل جيفري هينتون، إلى التحذير -في أكثر من مقابلة جرت معه- من مخاطر اختراعه. ووفق هينتون يمكن للذكاء الاصطناعي التوليدي أن يصبح في المستقبل القريب أذكى من الإنسان الذي أوجده، والتغيرات التي سيحدثها في سوق العمل لم تتضح بعد. وفي رسالة مفتوحة اقترح عدد من الباحثين ورجال الأعمال، من بينهم إيلون ماسك، التوقف عن تطوير الذكاء الاصطناعي حتى نهاية العام، كي يتسنى وضع قواعد له.

وجاء رد الاتحاد الأوروبي من خلال مشروع قانون تتم مناقشته منذ عامين، ومن حيث المبدأ يرى القانون أنه يجب تقسيم استخدامات الذكاء الاصطناعي إلى مستويات مخاطر مختلفة. فالأنظمة الخطرة جدا التي تحلل وتتنبأ بالسلوك الاجتماعي للناس بشكل غير مقبول، يجب حظرها. هذه الأنظمة الخطرة يجب أن تخضع للقواعد والحدود. أما الاستخدامات البسيطة للذكاء الاصطناعي مثل روبوتات المحادثة على غرار “تشات جي بي تي” فلا ينبغي تقييدها بشكل كبير. مع العلم أن كل الخدمات التي يتم توفيرها بواسطة الذكاء الاصطناعي يجب توضيحها بشكل بارز.

ومن المرجح أن يتواصل الانتظار حتى بداية عام 2025 ليكتمل قانون الذكاء الاصطناعي ويدخل حيز التنفيذ في أوروبا، إذ أنه ليس بحاجة إلى موافقة البرلمان الأوروبي فقط، وإنما يحتاج أيضا إلى موافقة جميع الدول الـ27 الأعضاء في الاتحاد. وبرامج الذكاء الاصطناعي مثل “تشات جي بي تي” لم تكن مطروحة في الأسواق قبل عامين ويمكن أن يكون الذكاء الاصطناعي قد تطور بشكل كبير حين تدخل قواعد الاتحاد الأوروبي حيز التنفيذ.

ويطالب مفوضو شؤون حماية البيانات في دول الاتحاد الأوروبي بإشراف مستقل على استخدامات الذكاء الاصطناعي والمزيد من التعديلات المتعلقة بحماية البيانات.

وبالنسبة إلى الشركات التي تريد توفير الاستخدامات المحفوفة بالمخاطر للذكاء الاصطناعي في أوروبا، يجب أن تستوفي جملة من الشروط الصارمة وتستعد لإدارة المخاطر المتعلقة بمنتجاتها. والبيانات والمعلومات التي يتم من خلالها تدريب برامج الذكاء الاصطناعي يجب فحصها من قبل الإنسان. والأشخاص الذين يقدمون المعلومات يجب إخبارهم بمجال استخدام معلوماتهم.

في أبريل الماضي حظرت هيئة حماية البيانات الإيطالية “تشات جي بي تي” لمدة قصيرة بسبب نقص في حماية البيانات، ورفعت الحظر بعدما أدخلت الشركة المطورة بعض التعديلات.

وفي ألمانيا تدرس جمعيات المراقبة التقنية والهيئة الاتحادية لأمن المعلومات ومعهد فراونهوفر للتحليل الذكي وأنظمة المعلومات، تقديم شهادات “سلامة” لاستخدامات الذكاء الاصطناعي. ومثلما هو الحال بالنسبة إلى السيارات التي يجب أن تخضع بشكل دوري لفحص تقني، يجب فحص استخدامات الذكاء الاصطناعي وتقديم شهادة تقنية من جهة مشرفة مستقلة؛ فاستخدام الذكاء الاصطناعي مثلا في السيارات ذاتية القيادة أو روبوتات العمليات الجراحية، يحتاج إلى ثقة كبيرة، يمكن أن تتعزز من خلال هذه الشهادة.