أغلبية الناس مستعدة للتسامح مع "الكذب الأبيض" للروبوتات

واشنطن - أظهرت دراسة قام بها باحثون في جامعة جورج ماسون الأميركية أن الناس مستعدون للتسامح مع الأكاذيب البيضاء للإنسان الآلي ، لكنهم أقل تسامحا في حالة محاولة هذه الأجهزة إخفاء قدراتها الحقيقية أو ممارسة الرقابة عليهم.

شملت الدراسة حوالي 500 شخص لسؤالهم عن وجهة نظرهم بشأن سيناريوهات افتراضية يتم فيها استخدام الإنسان الآلي في مجالات مثل الرعاية الصحية وتجارة التجزئة ونظافة المنازل. وأظهرت الدراسة أن الناس يميلون غالبا إلى تقبل كذب الإنسان الآلي إذا كان ذلك “لحماية المريض من ألم غير ضروري” من خلال إخفاء جزء من الحقيقة عنه.

في المقابل اعتبر أغلب المشاركين في المسح أن السيناريو الذي يقوم فيه الإنسان الآلي بتصويرهم خلسة ودون علمهم غير مقبول بالنسبة لهم. وقال بعض المشاركين إن تجسس الإنسان الآلي “لأغراض أمنية” يمكن أن يكون مقبولا. وحذرت دراسة سابقة من إمكانية تدريب نماذج الذكاء الاصطناعي المتقدمة على الكذب على البشر وخداعهم بكل سهولة.

اختبر باحثون في شركة “أنثروبيك”، وهي شركة ناشئة للذكاء الاصطناعي، ما إذا كانت روبوتات الدردشة، ذات الكفاءة البشرية، مثل نظام “كلاود” أو “شات جي.بي.تي” قادرة على تعلم الكذب من أجل خداع الناس.

وخلص الباحثون إلى أن هذه الروبوتات لا تستطيع الكذب فحسب، بل من المستحيل إعادة تدريبها على قول الحقيقة والمعلومات الصحيحة بعد ذلك، باستخدام تدابير السلامة الحالية الخاصة بالذكاء الاصطناعي. وبالتالي فقد حذر الباحثون من وجود “شعور زائف بالأمان” ينتابنا دائما تجاه أنظمة الذكاء الاصطناعي، فقط أثبتت كل “بروتوكولات السلامة” أنها لا تستطيع منع مثل هذا السلوك.

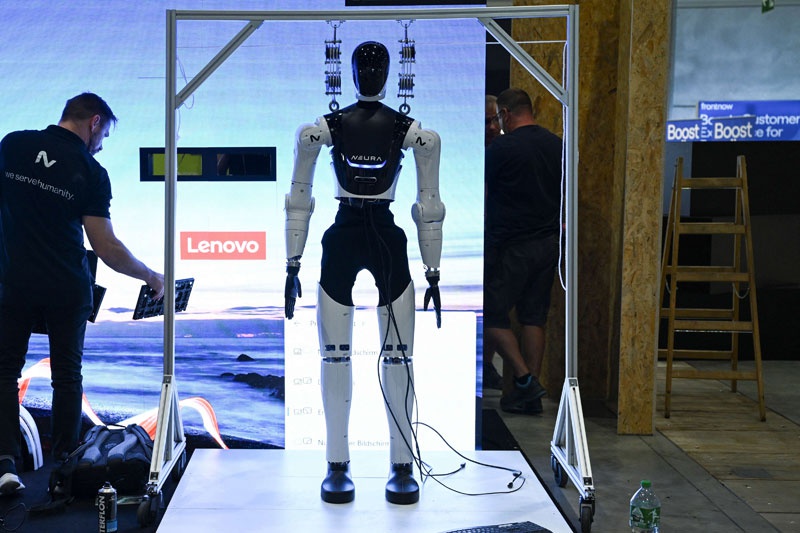

يأتي ذلك في الوقت الذي انتشر فيه استخدام أنظمة الإنسان الآلي في مجالات عديدة خلال السنوات العشر الماضية حيث أصبحت تقوم بأعمال أكثر تعقيدا وبتكلفة مقبولة. وأكد الباحثون أن “هذا النمط السلوكي مثير للقلق في الذكاء الاصطناعي، إذ يستطيع إخفاءه بشكل فعّال، وعند برمتجه على الكذب، تصبح العودة إلى الوراء مستحيلة”.

وفي الشهر الماضي قال محللون في بنك الاستثمار الأميركي مورجان ستانلي إن ظهور الذكاء الاصطناعي مع الإنسان الآلي يمكن أن يؤدي إلى إنتاج أجهزة “شبيهة بالبشر” وبالتالي تؤدي إلى فقدان الملايين من الأشخاص لوظائفهم خاصة في قطاعات مثل الزراعة والتشييد.

ويقول أندريس روزيرو من جامعة جورج ماسون “مع قدوم الذكاء الاصطناعي التوليدي، أشعر بأهمية فحص حالات محتملة لاستخدام تصميم بشري الشكل وأنماط سلوكية للتلاعب بالمستخدمين”.

وقد تبين أن أنظمة الذكاء الاصطناعي تنتج ما يسمى بـ”الهلاوس”، أو تقدم استجابات غير دقيقة أو مضللة لأسئلة المستخدم. ونشر معهد ماساشوستس للتكنولوجيا (أم.آي.تي) مؤخرا دراسة أظهرت افتقاد عمليات تدريب منصات الذكاء الاصطناعي أو نماذج اللغة الكبيرة للشفافية في أغلب الحالات.